Linux.raid

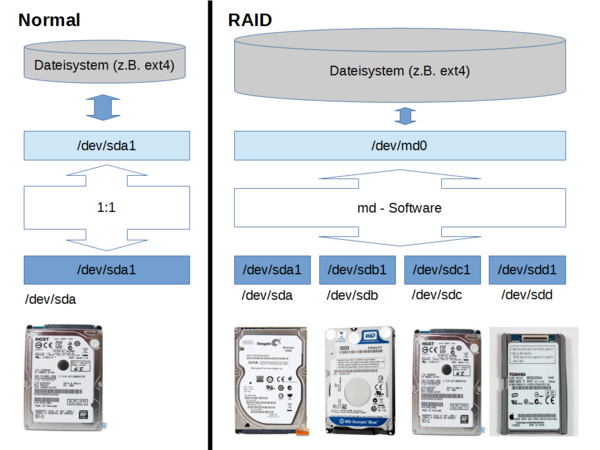

"md" ist ein Kernel Bestandteil von Linux mit dem man per Software ein RAID-System aufbauen kann. md stellt dem Linux System eine virtuelle Partition zur Verfügung (in der Regel "/dev/md0") die es "so" gar nicht real auf der/den Festplatte(n) gibt. Je nach RAID Level werden Schreib- Lesezugriff auf /dev/md0 durch die md-Software auf die realen Partitionen weitergegeben. RAID kann für mehr Datensicherheit sorgen (der Preis dafür ist geringe Geschwindigkeit sowie geringere Nettonutzinhalt der Partition), oder für höhere Zugriffsgeschwindigkeit (der Preis dafür die eine höhere Ausfallwahrscheinlichkeit), das alles jedoch unterhalb der Dateisystem-Ebene. Ich finde Software-RAID optimal, da das ganze Array von einem Mainboard auf ein anderes umgezogen werden kann. Auch von einem Kernel zu einem neueren. Es ist kein spezieller Controller nötig, der 2fach vorgehalten werden muss. Hier einige ausgesuchte Details - Infos ...

Vorwort

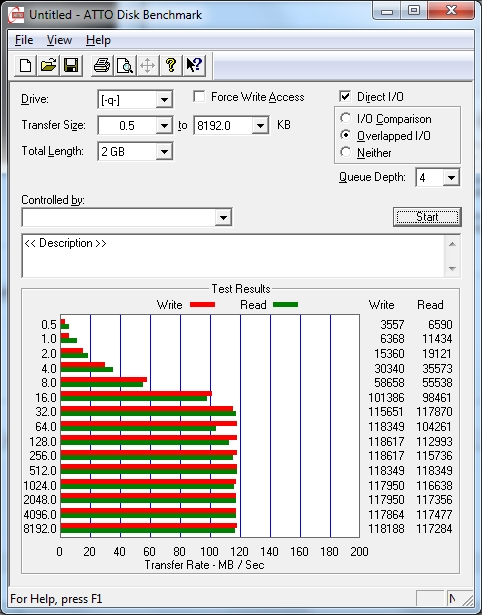

Also hier die Messergebnisse mit einem per 1GBit-LAN angebundenen Windows 7 Client. Das Netzwerk ist hier wohl das Limitierende Element.

Inbetriebnahme

Hardware

Versuchsaufbau

- Hier 4x 1 Terrabyte Festplatten von 2 unterschiedlichen Herstellern (2x ST1000NM0011, 2x WD1003FBYX) im Software RAID 5 Verbund

- Zum Booten und für das openSuSe 11.4 System verwende ich eine Intel SSD

- Man sieht im Versuchsaufbau die 4 Festplatten auf übergrosse Kühlkörper geschraubt

Software

- Auf allen RAID Platten des Verbundes: erstelle eine primäre & maximale Partition Typ "fd" (=Linux RAID autodetect)

yast - Erstelle eine raid-Partition aus den Einzelnen

mdadm --create --verbose /dev/md0 --level=6 --raid-devices=5 /dev/sd[bcdef]1 - Erstelle ein Filesystem auf der raid-Partition

mkfs.ext4 -m 0 /dev/md0

Infos

- Sich am besten mal im Wiki über RAID Level informiern

- Das Tool unter Linux heisst mdadm, und es ist überall gut dokumentiert

http://www.ducea.com/2009/03/08/mdadm-cheat-sheet/

- Nicht erschrecken, direkt nach dem erstellen eines RAID 5 Verbundes ist da einige Zeit ein "Spare" Drive, das verschwindet aber wenn das Array vollständig erzeugt ist. Schon in dieser Phase kann das Array benutzt also beschrieben werden.

http://www.spinics.net/lists/raid/msg34976.html

Betrieb

Vollständiger Lesecheck

echo check > /sys/block/mdX/md/sync_action

- Ist die Prüfung beendet lass Dir anzeigen ob es Lesefehler gab

cat readmismatch_cnt

Montoring

watch -n.4 'cat /proc/mdstat'

mdadm --detail /dev/md0

Umzug

- Das ganze Array einfach abklemmen, aber die SATA Kanal Reihenfolge auf dem neuen System wieder einhalten. Neu starten, die neue Partition mit dem richtigen FIlesystem mounten fertig.

- 3.0.101-95 nach 3.4.63-2.44 ist ohne Probleme gelungen

noch testen

- einfach mal runterfahren und 2 SATA Kabel vertauschen und wieder hochfahren (hihi!!!)

- im laufenden Betrieb eine Platte tauschen (ohne extra HotPlug-Stecker)

- warm swap: mit vorherigem -f oder -r

- devil swap: Strom weg und raus!

Vergrössern

- Für jede einzelne Platte gilt:

- alte Partition mit -f, -r aushängen

- bei neuer Platte eine maximale partition anlegen

- neue Platte mit maximal grosser Partition zum Array hinzuaddieren

- Dateisystem aushängen

- mdadm --grow ausführen, um das Array wachsen zu lassen

- Das Dateisystem auf die neue grösse Partition wachsen lassen

- Dateisystem einhängen

Autostart

- mit systemd.mount

- joe /etc/systemd/system/srv-smb-ra6.mount

[Unit] Description=srv-smb-ra6 [Mount] What=/dev/md0 Where=/srv/smb/ra6 [Install] WantedBy=local-fs.target