RAID6-2015: Unterschied zwischen den Versionen

Zur Navigation springen

Zur Suche springen

(→Layout) |

|||

| Zeile 99: | Zeile 99: | ||

11 8 81 - spare /dev/sdg1 Z9CAESQN | 11 8 81 - spare /dev/sdg1 Z9CAESQN | ||

8 8 1 0 active sync /dev/sda1 Z9CAEV9N | |||

1 8 17 1 active sync /dev/sdb1 J3NCSLRE | |||

9 8 49 2 active sync /dev/sdd1 Z1N3WJ16 | |||

7 8 113 3 active sync /dev/sdh1 36643628 | |||

6 8 81 4 active sync /dev/sdf1 32644607 | |||

10 8 65 5 active sync /dev/sde1 J1RLS9CR | |||

11 8 97 - spare /dev/sdg1 Z9CAESQN | |||

== Log-Buch == | == Log-Buch == | ||

Version vom 6. März 2023, 22:52 Uhr

4 TB nutzbare Kapazität, erstellt am Fri Nov 13 23:29:12 2015 auf maximal 16 TB erweiterbar, da ext4 ohne "64bit" Option 6x 1 TB Platten 1x 1 TB Platte als Spare 1x NVMe Systemplatte

Layout

|

|

- A1|A2|A3|A4|B1|B2|B3|B4 (Bay-Bezeichnungen von Links nach Rechts)

| Eigenschaften/Bay | A1 | A2 | A3 | A4 | B1 | B2 | B3 | B4 |

|---|---|---|---|---|---|---|---|---|

| Serial | Z9CAESQN |

Z1N3WJ16 |

WD-WCC4J1RLS9CR |

36643628 | 32644607 | Z9CAEV9N |

3NCSLRE | |

| Device | sdf | sdc | sdd | sdg | sde | sda | sdh | |

| RAID-Device | spare | 2 | 5 | 3 | 4 | 0 | 1 |

Devices

Version : 1.2

Creation Time : Fri Nov 13 23:29:12 2015

Raid Level : raid6

Array Size : 3906521088 (3725.55 GiB 4000.28 GB)

Used Dev Size : 976630272 (931.39 GiB 1000.07 GB)

Raid Devices : 6

Total Devices : 7

Persistence : Superblock is persistent

Intent Bitmap : Internal

Update Time : Fri Jan 3 10:42:50 2020

State : clean

Active Devices : 6

Working Devices : 7

Failed Devices : 0

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : bitmap

Name : linux-9st1:0

UUID : 2ca7d214:9c6bfab4:b2ecf28b:72df44ca

Events : 43021

Number Major Minor RaidDevice State

8 8 1 0 active sync /dev/sda1 Z9CAEV9N

1 8 17 1 active sync /dev/sdb1 WD-WCC4J3NCSLRE

9 8 33 2 active sync /dev/sdd1 Z1N3WJ16

7 8 97 3 active sync /dev/sdh1 WD-WCAW36643628

6 8 65 4 active sync /dev/sdf1 WD-WCAW32644607

10 8 49 5 active sync /dev/sde1 WD-WCC4J1RLS9CR

11 8 81 - spare /dev/sdg1 Z9CAESQN

8 8 1 0 active sync /dev/sda1 Z9CAEV9N

1 8 17 1 active sync /dev/sdb1 J3NCSLRE

9 8 49 2 active sync /dev/sdd1 Z1N3WJ16

7 8 113 3 active sync /dev/sdh1 36643628

6 8 81 4 active sync /dev/sdf1 32644607

10 8 65 5 active sync /dev/sde1 J1RLS9CR

11 8 97 - spare /dev/sdg1 Z9CAESQN

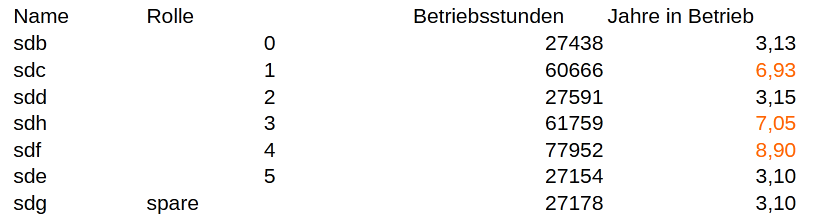

Log-Buch

14.02.2016 Produktiv

2017 Ausfall einer Platte, Platte hinzugefügt

28.02.2018 defekte Platte ausgebaut, Spare Platte dazugemacht

01.03.2018 Vollständiger Lesecheck OK

05.09.2018 sdf fiel durch I/O Errors auf, durch das spare ersetzt

12.10.2018 sdf durch eine neue Platte ersetzt (nur Hardware)

16.10.2018 sdf ist nun spare

30.11.2019 Vollständiger Lesecheck, sdb fiel durch Lesefehler massiv auf, durch spare sdf ersetzt

Betrieb ohne Spare, jedoch read-check 100% ok

03.12.2019 Besuch vor Ort, geklappere am Server, "sdf" wird vom raid6 rausgeworfen während ich da bin!

"sdf" ist auf "Faulty", array ist degraded

04.12.2019 sdb - stromlos geschaltet

"Z1N3WJ16" neu eingebaut, als "sdb" erkannt, als spare hinzugefügt->sofortiger resync, Erfolg!

(1. Platte)

sdf - Datenkabel abgezogen

"Z1M626HH" neu eingebaut, als "sdf" erkannt, ABER: Fehler bei gdisk, lehne Platte ab

(2. Platte) wird nicht mehr eingesetzt, ausgebucht!

Beschaffung von 4 weiteren Platten

11.12.2019 A2,B3 ausgebaut, neues Netzteil

A2 +"Z1N3WJ16" /sdf (Rolle "2")

B3 +"Z9CAEV9N" /sdb (Rolle "Spare")

data scrubbing

20.12.2019 -sdd [RD=0] Z1N07LHT mit 54413 Betriebsstunden, ersetzt durch spare sdb Z9CAEV9N

+sdi WD-WCC4J1RLS9CR am SAS 1/P1 (neu)

-sda [RD=5] WD-WCAW32647390 mit 54086 Betriebsstunden

+sdj Z9CAESQN am SAS 1/P2 (neu)

+nvme,

+openSUSE 15.1 (bisher 42.1)

+APC USV

27.01.2020 Lesefehler bei "sde" (WD-WCC4J1RLS9CR)

30.12.2020 ein Festplattenlüfter (Front, 3 Pin) macht Lärm, Austausch durch Kunde

28.08.2021 +nvme Samsung 980 PRO

+openSUSE 15.3 (bisher 15.1)

13.09.2021 Lesefehler bei "sde" (WD-WCC4J1RLS9CR)

15.02.2023 Entscheidung, auf SSDs mit 2 TB umzustellen

Beispiel für Zukunft: 2 + 2 + 2 + 2 + 2 + 2 + 2neu + 2neu [2] = 12 TB

Reserve

- 1 Netzteil

- 1 HDD

Sicherungskonzept

- Firebird: Stündliche Sicherungen auf die Systemplatte (nvme) zur vollen Stunde

- Firebird: Sicherungen um 06 Uhr, 9-17, 23 Uhr, jeweils in der Minute 30, jeweils 2 Tage zurück

- Firebird: Tägliche Sicherung in .\Datensicherungen, 4 Tage

- OrgaMon-Verzeichnis:

SicherungenAnzahl=12,5,5,5,* - J:\ Minor, 3 Sicherungen (wöchentlicher Wechsel) auf System "backup"

- J:\ Major, 10 Sicherungen (täglicher Wechsel) auf System "backup"

- externe Datensicherung durch Eigenentwicklung "bakexternal"

- J:\ täglich eine Woche lange auf externen Datenträger A

- J:\ täglich eine Woche lange auf externen Datenträger B

journalctl -e -nall -t bakexternal

crontab

# # Datenbank sichern # 00 * * * * root /root/firebird-backup-ssd.sh 30 6,9-17,23 * * * root /root/firebird-backup-ra6.sh # # Firebird # 00 10 * * * root chmod -R 777 /srv/firebird